- AMD는 노드 간 확장 성이있는 핫 칩 2025에 MI 350 시리즈를 게시합니다.

- MI355X DLC 랙에는 128 GPUS 36TB HBM3E 및 2.6 EXAFLOPS가 있습니다.

- 내년의 베라 루빈 시스템은 내년 최대 규모의 동물입니다.

AMD는 최신 Hot Chips 2025 이벤트를 사용하여 새로운 경향 MI350 시리즈를 강화하는 cDNA4 아키텍처에 대해 더 많이 이야기하고 가속기가 노드에서 랙으로 어떻게 조정되는지 보여줍니다.

MI350 시리즈 플랫폼은 UEC-S.-Sported 네트워킹과 OCP 표준 디자인에서 5 번째 Gene EPC CPU, MI350 GPU 및 AMD Polara NIC를 연결합니다. 대역폭은 끝없는 직물로 1075GB/s로 전달됩니다.

이것의 상단에는 Mi 355x DLC ‘ORV3’랙, 128 GPU가있는 2 개의 U 시스템, 36TB의 HBM3E E-Memory 및 FP4 정확도에 2.6 Exaflops가 있습니다 (96-GPU 버전의 HBM3E 27 TB.

여기 베라 루빈이 온다

노드 레벨에서 AMD는 공냉식 및 액체 냉각 시스템 모두에 대한 유연한 설계를 도입했습니다.

8 GPU가있는 1 개의 MI 350X 플랫폼은 플랫폼 FP8에서 73.8 Pateflops를 수신하는 반면, 액체 냉각 MI 355X 플랫폼은 댄서 폼 팩터에서 80.5 Petflops FP8에 도달합니다.

AMD는 또한 로드맵을 확인했습니다. 칩 대기업은 2024 년에 MI 325X를 출시했으며 MI 350 가족은 2025 년 초에 도착했으며 Instinct MI 400 2026에 출연 할 준비가되었습니다.

MI는 40 개의 PETFLOPS FP4, 20 PETFLOPS FP8, 432GB, 19.6 TB/S 대역폭 및 MI 400 GPU 당 300GB/s 스케일 아웃을 제공합니다.

AMD는 MI300에서 Mi 400까지의 영향 곡선이 추가 단계보다는 더 빠른 이득을 보여줍니다.

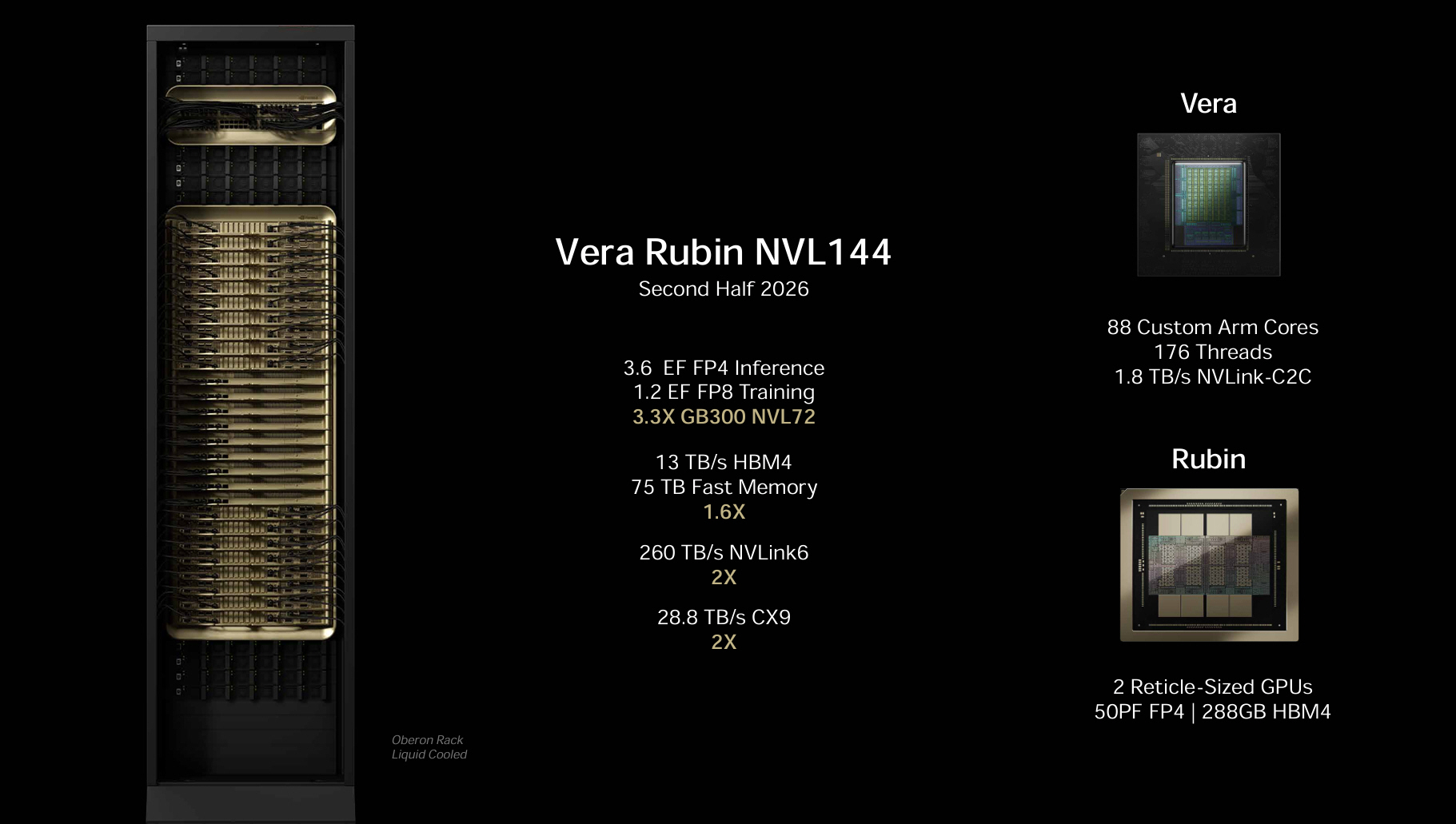

방에있는 코끼리는 자연스럽게 충분합니다. Nvidia는 2026-227 년 루빈 건축물을 계획하고 있습니다. 내년 하반기에 연필을 낸 Vera Rubin NVL 144 시스템은 Will (Nvidia가 공유 한 슬라이드에 따라), 6.6 Ex -Flops FP4 추론 및 1.5 Ex -Flops FP8 교육 등급으로 평가됩니다. 13TB/S HBM 4 대역폭과 75TB의 빠른 메모리가 있으며, 이는 전임자에게 1.6 배의 혜택을 얻습니다.

NVIDI는 NVIDI 1.8 TB/C에 의해 260TB/S 및 28.8TB/S의 CX9 상호 연결과 함께 176 개의 스레드와 88 개의 사용자 정의 팔 CPU 코로를 통합하고 있습니다.

2027 년 말 Nvidi는 Rubin Ultra NVL 576 시스템을 계획했습니다. 15 개의 Exaflops FP4 추론 및 5 개의 Exaflops FP8 훈련에 대해 평가되며, Nvilink 7 및 115tb/s와 1.5pb/s, 365 TB의 HBM 4E 대역폭 및 CX9를 사용하여 1.5pb/s의 상호 연결됩니다.

전체 규모로 Rubin 시스템에는 576 GPU, 2,304 HBM4E 스택 총 150TB 메모리 및 1,300 조 트랜지스터가 포함되며,이 트랜지스터는 12,672 Vera CPU 코어, 576은 -9 NIC, 72 Bluefield DPU 및 144 Novilink 스위치 Rats에 의해 지원됩니다.

최대 규모와 관련하여 엄격하게 통합 된 모 놀리 식 동물입니다.

AMD와 NVIDIA 수를 비교하는 것이 기쁨이지만 분명히 적절하지는 않습니다. AMD의 MI355X DLC 랙은 2025 년에 자세히 설명되어 있으며 Nvidi의 Rubin Systems 2026 및 2027에는 로드맵 디자인이 있습니다. 그럼에도 불구하고, 각 회사가 AI 인프라의 다음 물결을 구축하는 방법에 대한 흥미로운 점이 있습니다.